Résumé de la 4e séance de : Traitement temps réel et le langage musical

▪ jeudi 24 janvier de 10h00 à 12h00

Nous avons exploré la synthèse granulaire en employant le module munger (mng) dans tapemovie.

————————————————————

synthèse granulaire

————————————————————

wikipedia « Synthèse granulaire« :

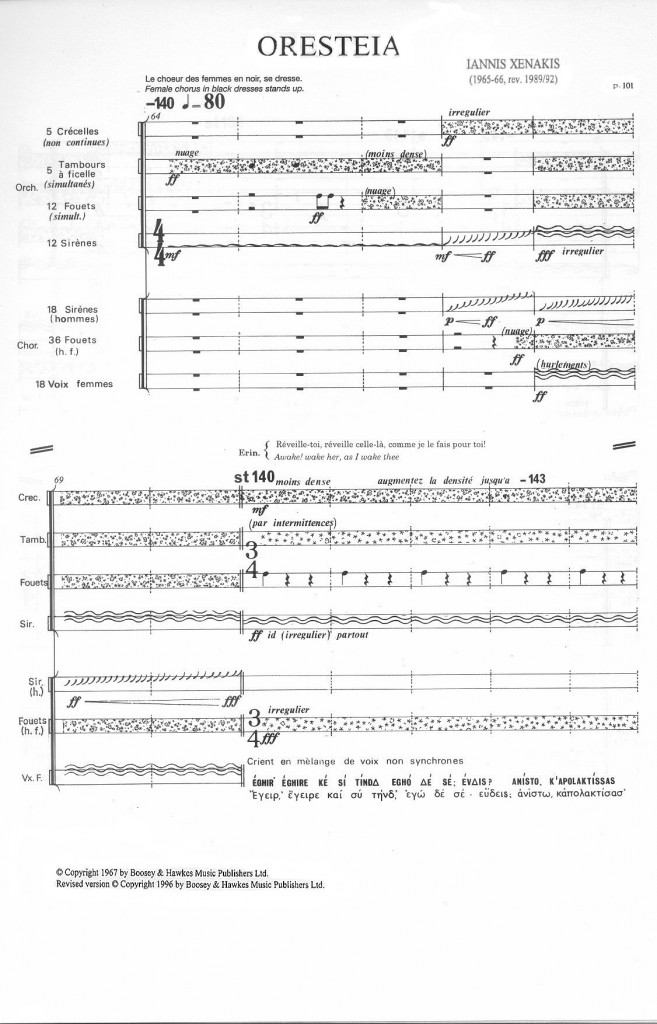

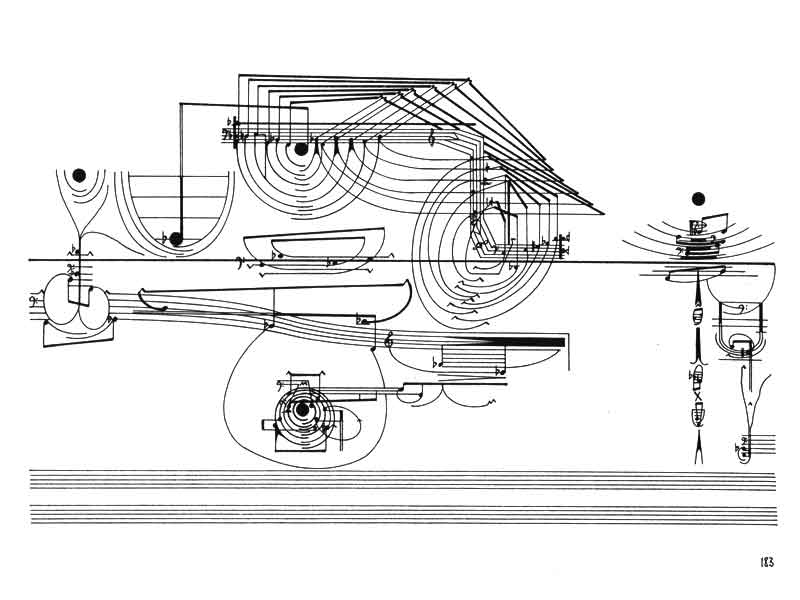

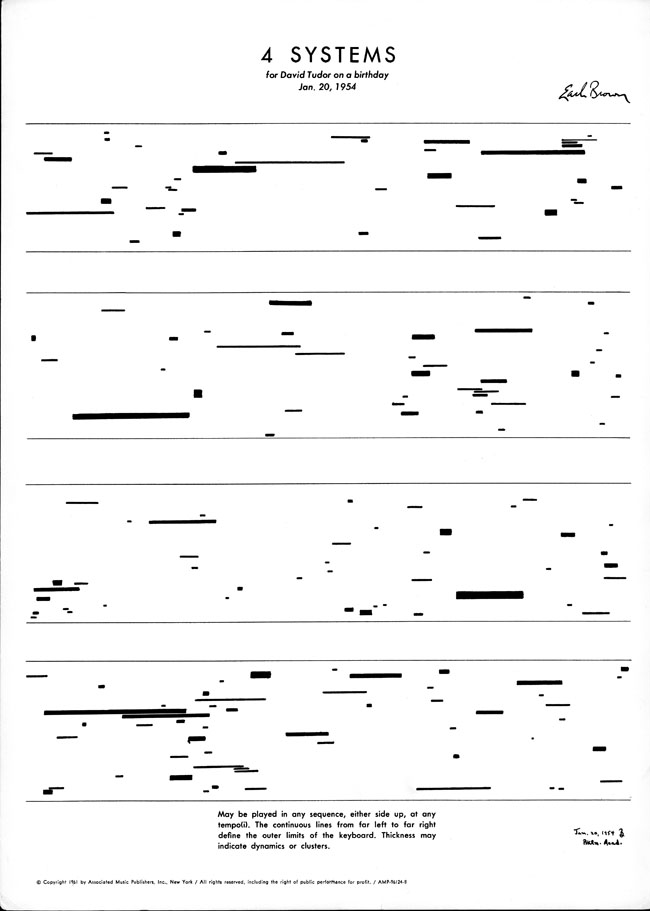

La synthèse granulaire est issue des recherches sur les micro-sons, particulièrement des travaux de Dennis Gabor en 1947. Iannis Xenakis fut parmi les premiers à en faire une utilisation musicale en 1958 avec la pièce pour bande ConcretePH. Le premier logiciel de synthèse granulaire est créé par Curtis Roads en 1978. Barry Truax écrira le premier moteur de synthèse granulaire temps réel en 1986 et s’en servira pour traiter des sources acoustiques (inventant donc la granulation).

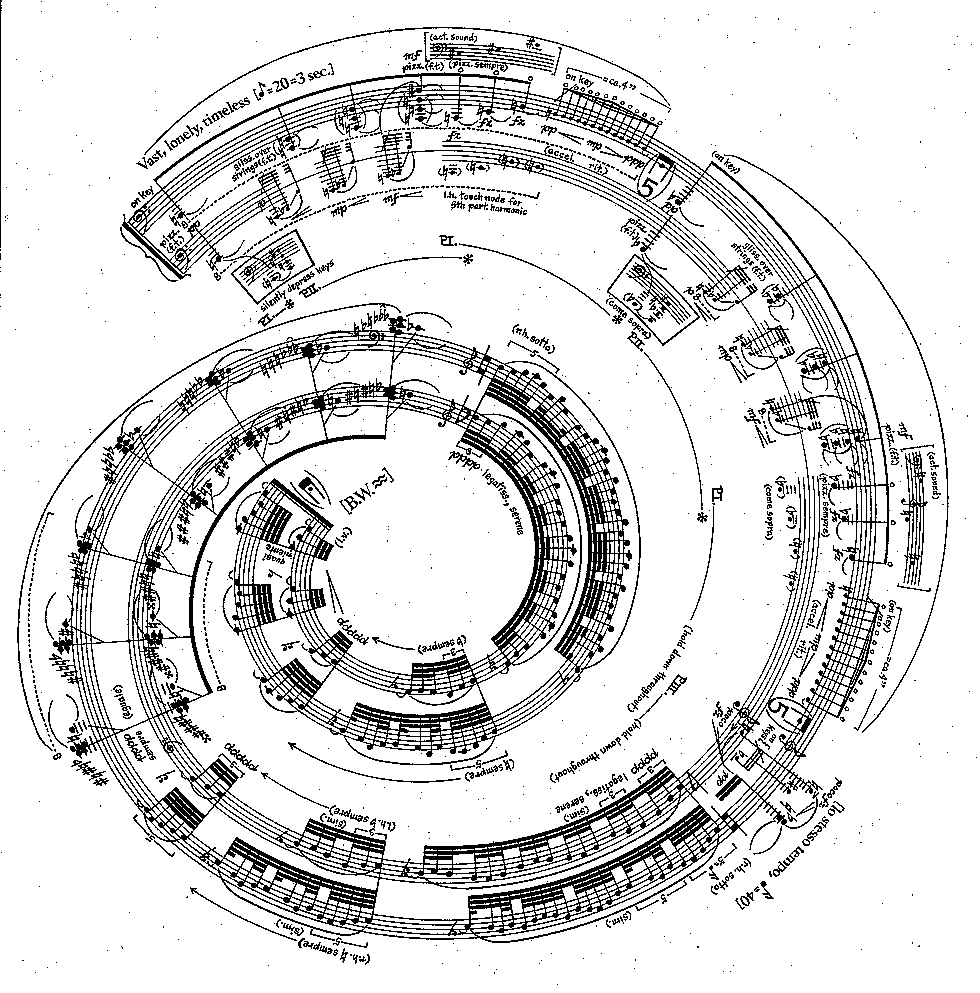

Le livre de référence sur la synthèse granulaire est Microsound de Curtis Roads, qui a lui-même composé plusieurs oeuvres électroacoustiques employant la synthèse granulaire. Beaucoup d’autres compositeurs ont utilisé cette technique, notamment Bary Truax qui a créé une oeuvre acousmatique d’envergure qui s’appalle Riverrun composé exclusivement avec la synthèse granulaire en temps réel en 1987. C’est une technique également très répandue en improvisation, car elle donne énormeément de possibilités de transformation et re-interprétation du son.

comment ça marche

L’idée de base est qu’un son « source » est est lu par petits grains, habituellement avec une durée de quelques millisecondes, et ces grains se combinent et se superposent de diverses manières pour créer des texures parfois riches, denses et complexes, et parfois très espacé et même rythmés. C’est un peu comme si on mettait un son dans une moulinette pour ensuite le « reconstituer » à sa guise.

Chaque lecure de « grain » a ses propriétés individuelles – position dans le son « source », intensité, durée, enveloppe, transposition, direction de lecture, panoramique… Chaque grain est déclenché par un « moteur » qui est un peu comme un métronome qui peut être très rapide (quelques millisecondes) ou très lent (quelques secondes), très régulier ou bien complètment aléatoire et arythmique. La densité du résultat est une fonction du temps entre chaque grain (vitesse de ce métronome) et la longeur (durée) des grains. Si des grains d’une durée de 100 ms sont lus toutes les 10 millisecondes, on va avoir une densité de 10 grains superposé, et on va avoir une texture plutôt dense, lisse et continue. Si on fait le contraire, des grains d’une durée de 10 ms lus toutes les 100 ms, on va avoir une texture éparse, transparent et plutôt pointilliste.

Le plupart des outils de synthèse granulaire fonctionne de la manière suivante (ou très similaire). On règle les paramètres globaux à la fois du moteur (temps entre chaque grain), et des grains eux-mêmes (position, intensité, durée, enveloppe, transposition, direction de lecture, pan…). Ensuite, on peut introduire une certaine variation aléatoire (ou stochastique) de chaque paramètre. C’est tout!

Des outils de synthèse granulaire diffèrent parfois par rapport à la manière de lire le son « source ». Typiquement, ils permettent de charger un son quelconque depuis un disque dur, ou bien parfois d’enregistrer un son venant d’une entrée micro. Dans ces 2 cas, le son est figé dans la mémoire vive et c’est la lecture décomposé/recomposé des grains qui le fait vivre.

Il existe aussi des outils granulaire qui utilise un espace de mémoire qui marche comme une ligne de retard – le son passe dans la ligne de retard en temps réel, avance petit à petit, puis disparait au bout du temps de retard. Les grains sont lus aléatoirement dans cette mémoire de son qui est constamment renouvelé, et qui reste « proche » du son direct.

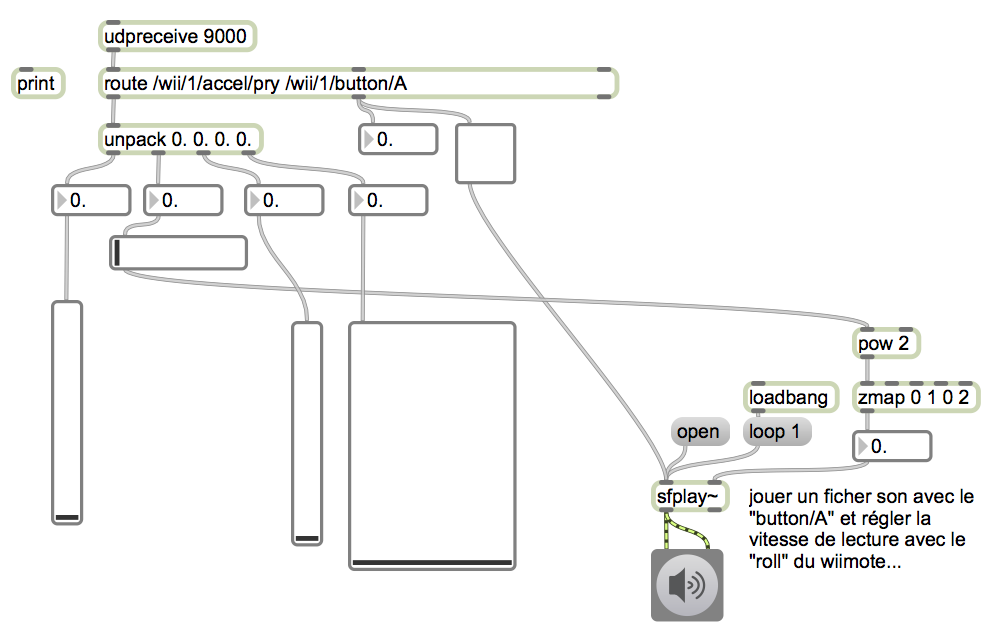

Un objet Max/MSP basé sur cette deuxième famille de moteurs de synthèse granulaire qui utilisent une « ligne de retard » est

munger~, écrit par Dan Trueman. C’est cette objet que le module « mng » dans tapemovie utilise également. Vous pouvez trouver un peu d’info sur cet objet ainsi que des liens pour le télécharger ici -> http://www.roaldbaudoux.org/index.php?option=com_content&view=article&id=62:munger&catid=51:objets-complementaires

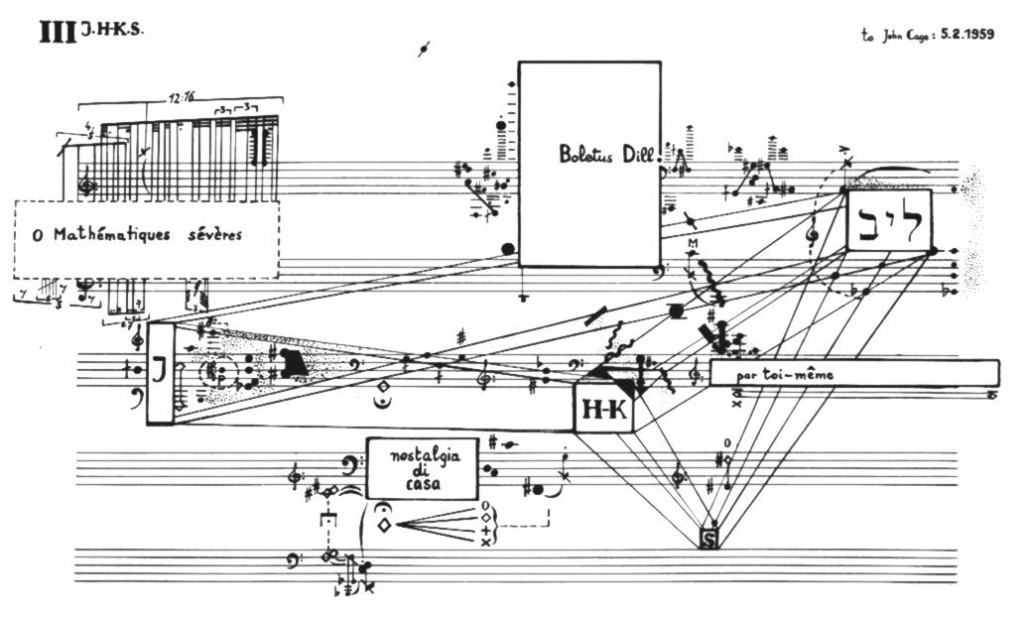

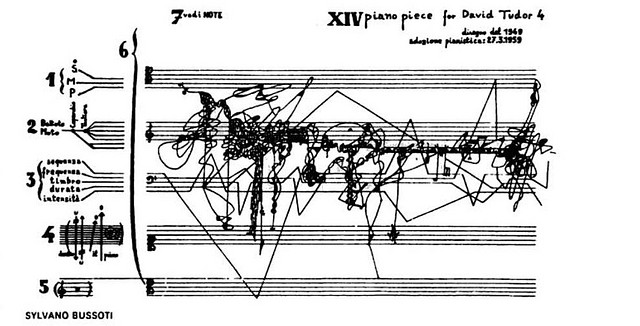

le travail musical

Beaucoup de possibilités existent de recomposition de la matière sonore, avec ou sans éléments aléatoires des paramètres de hauteur, intensité, temps, durée, enveloppe, pan et éventuellement gamme de transposition.

Un facteur important est que si les paramètres de la synthèse granulaire n’évoluent pas dans le temps, l’auditeur peut s’ennuyer assez vite. Il est donc important que les paramètres évoluent, mais aussi ils peuvent être interprétés par un contrôleur gestuel.

Avec la synthèse granulaire de type « munger » nous avons aussi le problème du non-maintenance du son – si l’instrument « source » arrête de jouer, au bout du temps de délai, le son granulaire s’arrête aussi. On peut prolonger le son avec un ou plusieurs délais pour le maintenir. Dans nos essaies en cours, nous avons passé le son par un délai « fibonacci » (delfib dans tapemovie) qui peut prolonger facilement plusieurs secondes ou mêmes plus d’une minute.

————————————————————

impros / essaies

————————————————————

Nous avons fait quelques essaies d’improvisation avec vibraphone, flûte et saxophone.

—