Le Traitement temps réel et le langage musical

11 janvier 2013

Résumé de la 3e séance de : Traitement temps réel et le langage musical

▪ un seul groupe : vendredi 11 janvier de 10h00 à 12h00

Pour cette 3e séance nous avons exploré la modulation en anneau et le frequency shifting (transposition de fréquence).

————————————————————

la modulation en anneau et le frequency shifting

————————————————————

comment ça marche

La modulation en anneau est surement le traitement le plus perceptible et le moins risqué à faire en temps réel de tous. Cette transformation est perceptible car le spectre et donc le timbre du son est modifié de façon significative et cette « séparation » du son traité du son d’origine augmente très fortement sa perceptibilité. Le même décalage du spectre qui rend la modulation en anneau perceptible diminue énormément les risques d’effet Larsen, car les fréquences qui sortent des haut-parleurs ne sont pas les même que celles qui rentrent par le microphone. Ainsi on empêche le « renforcement » qui provoque l’effet Larsen.

Pour faire une modulation en anneau on prend un signal complexe (entrée micro par exemple) et on le multiplie avec un oscillateur sinusoïdal « bipolaire » (oscillation positif et négatif autour de « 0 »). Le résultat est la somme ET la différence de toutes les fréquences du signal complexe (porteuse) avec la fréquence de l’oscillateur.

Si un son complexe avec un spectre harmonique de 1000 Hz, 2000 Hz, 3000 Hz et 4000 Hz est modulé à 250 Hz, le résultat est:

| différence | somme |

| 750 | 1250 |

| 1750 | 2250 |

| 2750 | 3250 |

| 3750 | 4250 |

… et le son direct disparait. Puisqu’il n’y a plus de rapport « harmonique » entre les partiels de ce résultat, le son est « inharmonique ».

Si on module un son complexe par une fréquence égale à la fondamentale, on retrouve un son quasi identique à l’original. Par exemple, on va moduler 100-200-300-400 Hz avec 100Hz et on va avoir :

| différence | somme |

| 0 | 200 |

| 100 | 300 |

| 200 | 400 |

| 300 | 500 |

Le 0 Hz va disparaitre de la perception car 0Hz n’est pas audible, et le reste va faire un son parfaitement aligné avec le spectre du son d’origine, avec un partiel de 500 Hz en plus. Dans le résultat, le 100Hz sera un peu moins fort que le 100 Hz dans le son d’origine car c’est le 2e harmonique décalée plus bas, mais globalement on aura un timbre très proche.

Ça voudrait dire que pour différents « rapports » entre la hauteur du son d’origine et la fréquence de modulation, on a différents timbres entres « harmoniques » et « inharmoniques ». Les changements de timbres s’effectuent donc soit en changeant la fréquence de modulation sur une hauteur constante, soi en changeant la hauteur sur une fréquence de modulation constante.

Si la fréquence de modulation et très basse, entre 0Hz et 20Hz, le résultat est un son avec des « battements » – un effet de « lfo ». Les battements sont d’une fréquence de 2 fois plus que la fréquence de modulation car c’est le résultat d’une confrontation entre l’original MOINS la fréquence de modulation et PLUS la fréquence de modulation (i.e. mod avec 1Hz fait un ambitus de 2Hz, donc battements de 2Hz également).

Si la fréquence de modulation est au dessus de la fondamentale de la note jouée, la « différence » crée une fréquence qui descend en dessous de 0Hz. Dans ce cas la fréquence se trouve « repliée » autour de zéro et redevient positive, subissant juste une inversion de phase.

Les sons très bruités marche moins bien ou pas du tout avec la modulation en anneau car le bruit « blanc » contient déjà de l’énergie dans tout le spectre, donc des modifications de ce spectre de bruit ne sont pas bien perceptibles. Par contre, les modulations de basses fréquences, puisque elle créent des battements (effet de changement d’amplitude) sont bien perceptibles sur du bruit.

La Frequency Shifting (transposition de fréquence) est en effet une « moitié » d’une modulation en anneau – uniquement la somme ou uniquement la différence. On peux bien sûr recombiner un frequency shifting « haut » et un frequency shifting « bas » pour retrouver exactement la même chose qu’une modulation en anneau.

Pour d’autres information sur la modulation en anneau (ou bien ring modulation) l’article sur wikipedia en anglais n’est pas mal:

http://en.wikipedia.org/wiki/Ring_modulation

le travail musical

Le travail musical avec modulation en anneau et/ou frequency shifting tourne autour globalement de trois axes de travail qui correspondent à trois « zones » de fréquences:

- Création de « battements » avec des fréquences basses de modulation. Les valeurs les plus marquées sont probablement entre 0Hz et 10Hz.

- Création d’un « ‘instrument préparé » où chaque note de l’instrument sonne avec un timbre différent. Dans ce cas on « accord » la modulation à une note quelque part au milieu de la tessiture de l’instrument.

- Un effet de « scintillement » ou une sorte de « pédale » aiguë en utilisant une fréquence de modulation bien au dessus des notes jouées par l’instrument.

Pour les premiers deux techniques, le son transformé est tellement lié à l’instrument acoustique qu’on a l’impression que l’instrument lui-même a été modifié. Par exemple, si on utilise la modulation pour créer des fausses « multiphoniques » sur l’instrument, il est TRES difficile pour l’auditeur d’entendre que c’est un traitement et non pas une vraie multiphonique! Pareil pour les battements qu’on a plus tendance à croire que l’instrumentiste les fait lui-même.

Le troisième technique se détache de l’instrument car le scintillement aiguë est bien au dessus de la tessiture de l’instrument et car il ne change pas de façon significative avec chaque note. Dans cette zone de fréquences, nous avons plutôt un « effet » qu’une réelle transformation de l’instrument.

En travaillant musicalement avec la modulation en anneau, il faut penser aux possibilités de ces trois « axes » de travail, en trouvant des moyens de CHANGER la fréquence de modulation pour varier le résultat musical – de préférence lié aux phrases musicales.

On peux aussi mettre plusieurs modulateurs en parallèle pour densifier le résultat, ou bien n’utiliser qu’un coté d’une frequency shifting pour épurer la densité.

On peux également modifier les paramètres de la modulation ou le niveau d’écoute de la modulation avec des détections de paramètres du son joué comme l’enveloppe d’amplitude ou la hauteur.

Il faut chercher et expérimenter.

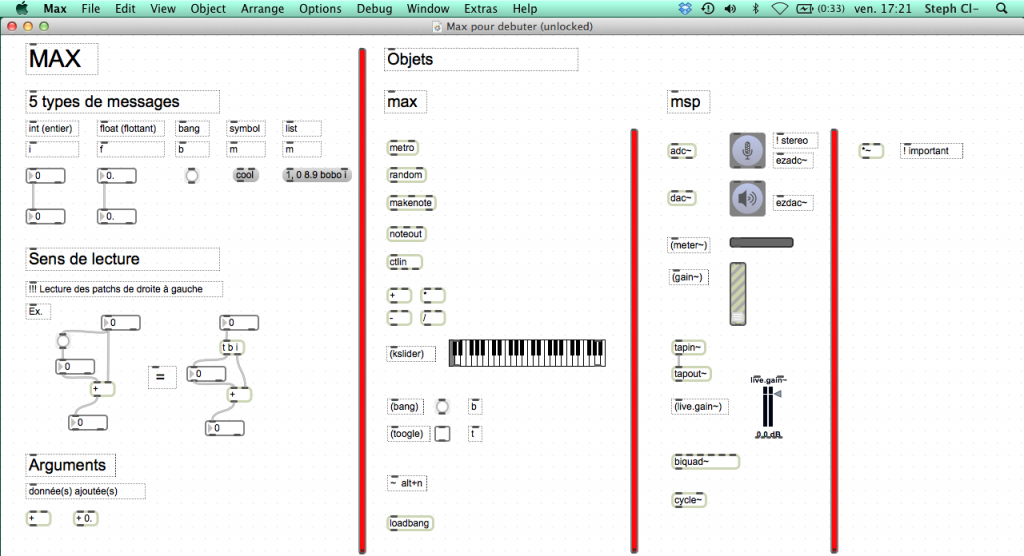

Il y a l’objet « fshift~ » dans Max, mais aussi le module fshift dans tapemovie.

————————————————————

impros / essaies

————————————————————

Nous avons donc faire plusieurs essaies d’improvisation et d’écoute pour découvrir musicalement les possibilités

Nous avons joué voix, saxophone, flûte…